Transkripsi cloud sudah mati. Hanya saja belum tahu.

Selama setahun terakhir, kami mengamati pergeseran struktural dalam alat transkripsi suara. Dulu solusi cloud mendominasi pasar karena bisa menjalankan model yang lebih besar. Keunggulan itu telah hilang. Sekarang MacBook Anda dapat menjalankan Whisper Large-v3 Turbo dengan 809 juta parameter. iPhone Anda dapat menjalankan model yang dioptimalkan sepenuhnya offline. Realitas rekayasa telah berubah, dan kebanyakan orang belum menyadarinya.

Whisper Notes: Transkripsi Offline Tingkat Profesional

Persamaan Latensi Telah Berubah

Transkripsi cloud memiliki lantai latensi tetap: unggah audio + antrean server + inferensi model + unduh hasil. Bahkan dalam kondisi jaringan ideal, ini berarti penundaan bolak-balik beberapa detik. Jika jaringan tidak stabil, bisa menjadi puluhan detik.

Inferensi lokal menghilangkan variabel-variabel ini. Whisper Large-v3 Turbo di Apple Silicon dapat mencapai transkripsi streaming hampir real-time saat Anda berbicara. Tidak ada menunggu unggahan, tidak ada jitter jaringan, tidak ada antrean server.

Data pengukuran kami: Di MacBook Air M1, Large-v3 Turbo memproses audio 9-10x kecepatan pemutaran. Rekaman 10 menit ditranskripsi dalam sekitar 63 detik. Ini bukan performa puncak, tapi throughput berkelanjutan yang dapat direproduksi.

Arsitektur Adaptif Perangkat Keras

Tidak semua perangkat dapat menjalankan model yang sama. Ini bukan batasan, tapi desain rekayasa yang disengaja.

Mac (Large-v3 Turbo, 809 juta parameter)

MacBook dan Mac memiliki catu daya berkelanjutan, pendinginan aktif, dan memori yang cukup. Ini memungkinkan menjalankan Large-v3 Turbo penuh—model ini mempertahankan akurasi Large-v3 sambil meningkatkan kecepatan inferensi 4-5x. Anda mendapatkan akurasi tingkat cloud dengan kecepatan tingkat lokal.

iPhone (Varian Whisper yang Dioptimalkan)

Chip mobile beroperasi di bawah batasan daya dan termal. Kami menerapkan varian Whisper yang dioptimalkan untuk Neural Engine, mempertahankan akurasi yang sangat baik dalam anggaran daya. Trade-off-nya jelas: ukuran model lebih kecil dibandingkan Large-v3 Turbo, tapi tanpa latensi jaringan dan bekerja secara konsisten dan akurat di ponsel.

Pendekatan adaptif perangkat keras ini berarti setiap perangkat menjalankan model optimal yang dapat dijalankannya secara efisien. Bukan "model yang sama di mana-mana", tapi "model yang tepat untuk setiap perangkat".

Sepenuhnya Offline: Impor Audio dan Transkripsi Langsung

Privasi adalah Arsitektur, Bukan Fitur

Sebagian besar layanan transkripsi cloud memiliki kebijakan privasi yang menjanjikan untuk melindungi data Anda. Tapi arsitektur membuat kebijakan privasi tidak relevan.

Saat audio melewati jaringan, Anda kehilangan kendali atasnya. Bisa dicatat, di-cache, digunakan untuk pelatihan, atau dipanggil. Bahkan dengan kebijakan niat terbaik, keberadaan data di server itu sendiri adalah permukaan serangan.

Pemrosesan lokal menghilangkan permukaan serangan ini. Rekaman tidak pernah meninggalkan perangkat Anda. Tidak ada log transfer, tidak ada penyimpanan sisi server, tidak ada kemungkinan akses pihak ketiga. Ini bukan tentang mempercayai kami, tapi menghilangkan kebutuhan akan kepercayaan.

Dampak praktis: Profesional medis, pengacara, jurnalis—siapa pun yang menangani percakapan sensitif—tidak perlu lagi mempertimbangkan trade-off antara kenyamanan transkripsi dan kewajiban kerahasiaan. Arsitektur offline memungkinkan keduanya.

Kapan Cloud Masih Masuk Akal

Posisi local-first kami didasarkan pada rekayasa, bukan dogma. Ada skenario di mana solusi cloud masih masuk akal:

- Kolaborasi Real-Time Multi-Orang: Jika 10 orang perlu melihat transkripsi real-time secara bersamaan, server bersama adalah pilihan arsitektur yang masuk akal.

- Perangkat Lama dengan Penyimpanan Terbatas: Jika perangkat tidak dapat menampung file model, cloud adalah alternatif yang layak.

- Model Bahasa Khusus: Bahasa atau dialek yang sangat niche mungkin memiliki model khusus cloud.

Namun, untuk rekaman pribadi, catatan rapat, memo suara, wawancara—sebagian besar kasus penggunaan kebanyakan orang—pemrosesan lokal unggul dalam latensi, privasi, dan keandalan.

Kebenaran Tentang Akurasi

Kesalahpahaman umum: model cloud yang lebih besar berarti akurasi lebih tinggi. Itu benar di tahun 2022. Tidak lagi sekarang.

Whisper Large-v3 Turbo adalah model distilasi—belajar dari Large-v3 penuh, mempertahankan akurasi sambil mengurangi persyaratan komputasi. Pada benchmark standar, mencapai word error rate setara dengan model penuh sambil inferensi 4-5x lebih cepat.

Batasan yang jujur: Code-switching (mencampur beberapa bahasa dalam rekaman) masih menjadi tantangan. Model tidak otomatis mempelajari kosakata Anda; Anda harus memberitahunya apa yang akan didengar.

Perbandingan Model Ekonomi

Transkripsi cloud berbasis langganan memiliki biaya berkelanjutan—biaya per menit atau biaya bulanan. Ini terlihat murah untuk pengguna sesekali, tapi terakumulasi dengan cepat untuk pengguna berat.

| Layanan | Model Harga | Biaya 2 Tahun |

|---|---|---|

| Otter.ai | $16.99/bulan | $407 |

| Rev | $0.25/menit | Bervariasi |

| Whisper Notes | $4.99 sekali bayar | $4.99 |

Ekonomi pemrosesan lokal berbeda: pembelian sekali (harga kami $4.99), kemudian biaya marginal mendekati nol. Biaya tambahan untuk rekaman 10 menit dan rekaman 10 jam sama: nol.

Ini bukan tentang "murah", tapi tentang prediktabilitas model biaya. Ketika alat tidak mengenakan biaya berdasarkan penggunaan, Anda dapat menggunakannya lebih bebas.

Fitur Praktis

Setiap fitur yang kami bangun adalah respons terhadap masalah yang diamati:

Widget Layar Kunci

Kami mengamati bahwa rekaman paling berharga sering dibutuhkan secara tiba-tiba—ilham, percakapan kebetulan, panggilan penting yang tidak terduga. Rekaman satu ketukan dari layar kunci menghilangkan hambatan ini.

Rekam Langsung dari Layar Kunci, Jangan Lewatkan Inspirasi

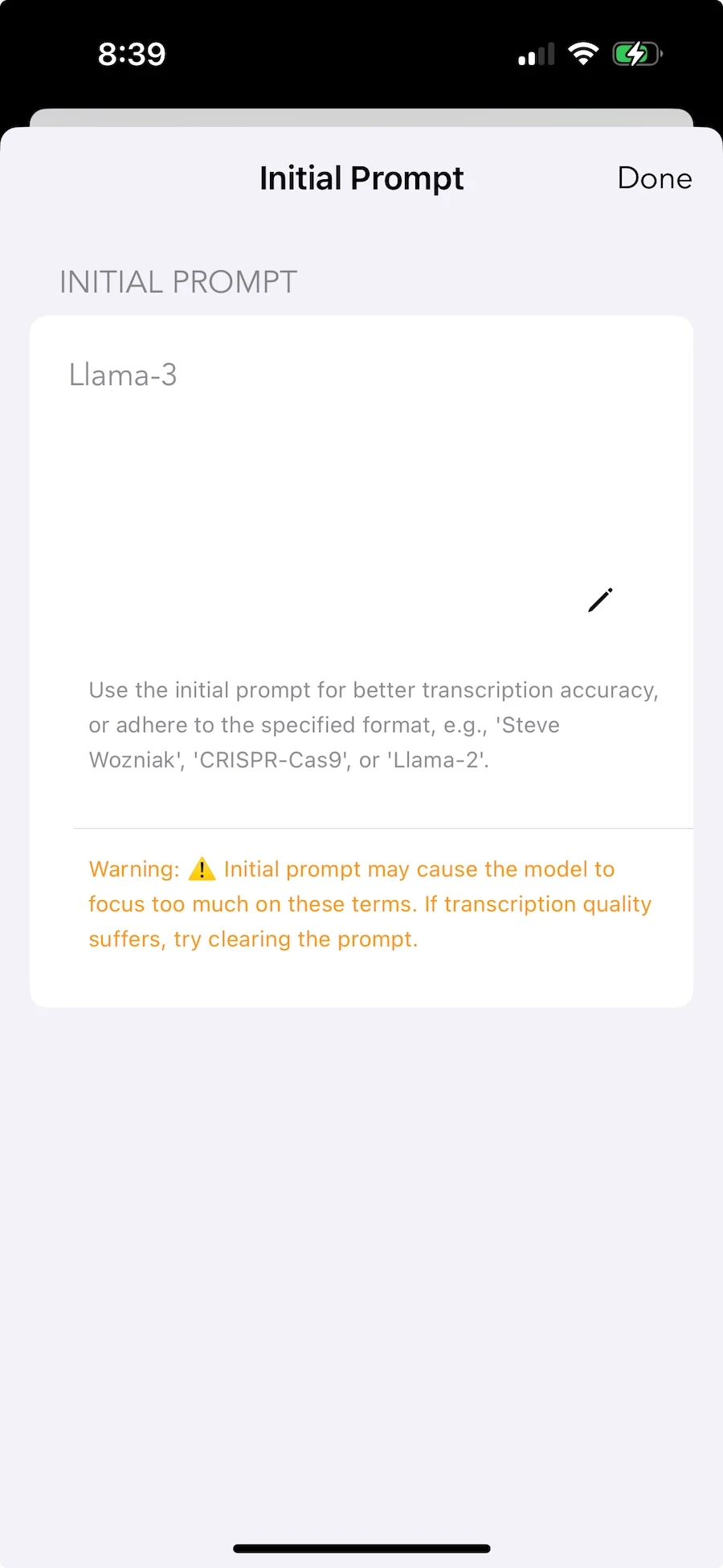

Initial Prompt (Kosakata Kustom)

Whisper berkinerja baik pada konten umum, tapi setiap bidang memiliki istilah yang tidak dikenali. Terminologi medis, istilah hukum, nama internal, singkatan teknis. Initial prompt memungkinkan Anda memberi tahu model sebelumnya "kata-kata ini akan muncul, tolong kenali dengan benar".

Atur Istilah Khusus untuk Meningkatkan Akurasi Pengenalan

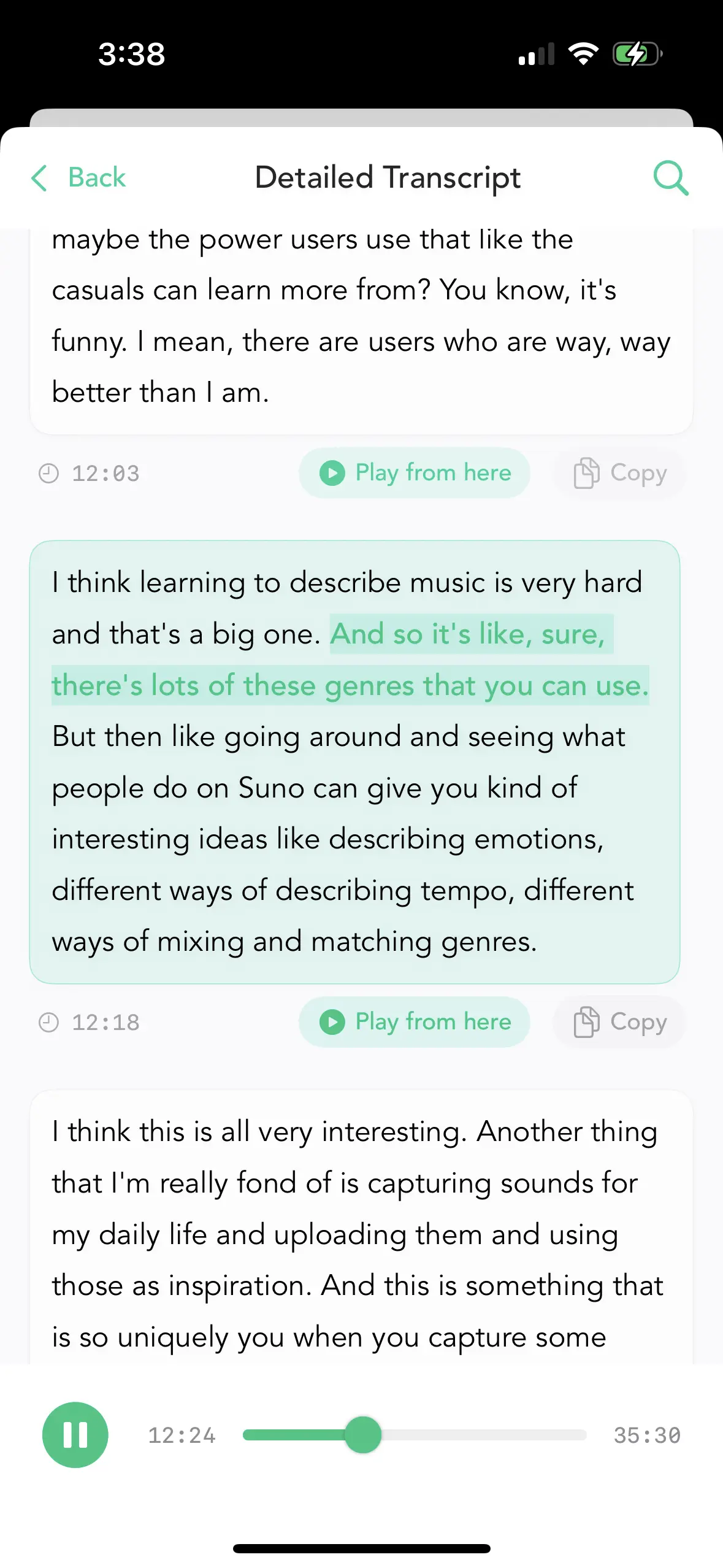

Paragraf dengan Timestamp

Nilai rekaman panjang sering terletak pada segmen tertentu. Tanpa timestamp, Anda harus mendengarkan seluruh rekaman untuk menemukan kalimat itu. Dengan timestamp yang dapat diklik, Anda dapat langsung melompat ke bagian yang relevan.

Tentukan Posisi dengan Tepat Menggunakan Timestamp, Lompat dengan Cepat

Ekspor Massal

Peneliti, jurnalis, pengacara sering memproses puluhan rekaman sekaligus. Mengekspor satu per satu adalah alur kerja yang tidak dapat diterima. Operasi massal membuat ini praktis.

Pilih Massal, Ekspor Sekaligus

Multibahasa: 80+ Bahasa

Data pelatihan Whisper mencakup 99 bahasa, tapi kedalaman cakupan bervariasi. Bahasa utama seperti Inggris, Mandarin, Spanyol, Jerman, Jepang memiliki banyak data pelatihan dan akurasi sangat tinggi. Bahasa minor mungkin berkinerja sedikit lebih rendah, tapi biasanya masih dapat digunakan.

Kesimpulan: Pilihan Rekayasa

Kami membangun Whisper Notes karena inferensi AI lokal lebih unggul dalam transkripsi suara—dalam latensi, privasi, keandalan, dan biaya. Ini bukan tentang "menentang cloud" atau "percaya pada local-first". Ini tentang mengakui bahwa kondisi teknis telah berubah dan membangun alat berdasarkan itu.

Whisper Large-v3 Turbo di Mac dan model yang dioptimalkan di iPhone mewakili keseimbangan optimal yang benar-benar dapat dijalankan oleh perangkat keras saat ini. Saat perangkat keras terus maju—dan akan demikian—kami akan menerapkan model yang lebih besar. Tapi bahkan hari ini, pemrosesan lokal cukup untuk sebagian besar tugas transkripsi suara dan unggul dalam metrik utama.

Jika pendekatan arsitektur ini sesuai dengan kebutuhan Anda, Anda dapat mencobanya di bawah.