Molntranskription är död. Den vet bara inte om det ännu.

Under det senaste året har vi observerat en strukturell förändring i verktyg för rösttranskription. Molnlösningar dominerade tidigare marknaden eftersom de kunde köra större modeller. Den fördelen har försvunnit. Nu kan din MacBook köra Whisper Large-v3 Turbo med 809 miljoner parametrar. Din iPhone kan köra optimerade modeller helt offline. Den ingenjörsmässiga verkligheten har förändrats, och de flesta har inte märkt det ännu.

Whisper Notes: Professionell offline-transkription

Latensekvationen har förändrats

Molntranskription har ett fast latensgolv: ljuduppladdning + serverkö + modellinferens + resultatnedladdning. Även under ideala nätverksförhållanden innebär detta flera sekunders rundresa. Med instabilt nätverk kan det bli tiotals sekunder.

Lokal inferens eliminerar dessa variabler. Whisper Large-v3 Turbo på Apple Silicon kan leverera strömmande transkription nästan i realtid medan du talar. Ingen väntan på uppladdning, ingen nätverksjitter, inga serverköer.

Våra mätdata: På M1 MacBook Air bearbetar Large-v3 Turbo ljud med 9-10x uppspelningshastighet. En 10-minuters inspelning transkriberas på cirka 63 sekunder. Detta är inte topprestanda, utan hållbar och reproducerbar genomströmning.

Hårdvaruadaptiv arkitektur

Inte alla enheter kan köra samma modell. Detta är inte en begränsning, utan avsiktlig ingenjörsdesign.

Mac (Large-v3 Turbo, 809 miljoner parametrar)

MacBooks och Mac-datorer har kontinuerlig strömförsörjning, aktiv kylning och tillräckligt med minne. Detta möjliggör körning av fullständig Large-v3 Turbo—en modell som behåller Large-v3:s noggrannhet samtidigt som inferenshastigheten förbättras 4-5x. Du får molnnivå noggrannhet med lokal hastighet.

iPhone (optimerade Whisper-varianter)

Mobila chip arbetar under kraft- och värmebegränsningar. Vi distribuerar Whisper-varianter optimerade för Neural Engine som upprätthåller utmärkt noggrannhet inom kraftbudgeten. Avvägningen är tydlig: mindre modellstorlek jämfört med Large-v3 Turbo, men ingen nätverksfördröjning och konsekvent noggrannhet på telefonen.

Detta hårdvaruadaptiva tillvägagångssätt innebär att varje enhet kör den optimala modellen den effektivt kan köra. Inte "samma modell överallt", utan "rätt modell för varje enhet".

Helt offline: Importera ljud och transkribera direkt

Integritet är arkitektur, inte en funktion

De flesta molntranskriptionstjänster har integritetspolicyer som lovar att skydda dina data. Men arkitekturen gör integritetspolicyer irrelevanta.

I samma ögonblick som ljud passerar nätverket förlorar du kontrollen över det. Det kan loggas, cachas, användas för träning eller stämmas. Även med policyer med bästa avsikter är datans existens på en server i sig en attackyta.

Lokal bearbetning eliminerar denna attackyta. Inspelningar lämnar aldrig din enhet. Inga överföringsloggar, ingen serverlagring, ingen möjlighet till tredjepartsåtkomst. Det handlar inte om att lita på oss, utan om att eliminera behovet av förtroende.

Praktisk påverkan: Vårdpersonal, advokater, journalister—alla som hanterar känsliga samtal—behöver inte längre väga transkriptionsbekvämlighet mot sekretesskyldigheter. Offline-arkitektur gör båda möjliga.

När molnet fortfarande är meningsfullt

Vår ståndpunkt för lokal-först baseras på ingenjörskonst, inte dogm. Det finns scenarier där molnlösningar fortfarande är meningsfulla:

- Realtidssamarbete med flera personer: Om 10 personer behöver se realtidstranskription samtidigt är en delad server ett rimligt arkitekturval.

- Äldre enheter med lagringsbegränsningar: Om din enhet inte kan rymma modellfiler är molnet ett genomförbart alternativ.

- Specialiserade språkmodeller: Extremt nischade språk eller dialekter kan ha molnexklusiva modeller.

Men för personliga inspelningar, mötesanteckningar, röstmemon, intervjuer—de flesta användningsfall för de flesta människor—vinner lokal bearbetning på latens, integritet och tillförlitlighet.

Sanningen om noggrannhet

En vanlig missuppfattning: större molnmodeller betyder högre noggrannhet. Det var sant 2022. Inte längre.

Whisper Large-v3 Turbo är en destillerad modell—tränad från fullständig Large-v3, bevarar noggrannhet samtidigt som beräkningskraven minskas. På standardbenchmarks uppnår den jämförbar ordfelfrekvens med fullmodellen samtidigt som inferenshastigheten är 4-5x snabbare.

Ärlig begränsning: Kodväxling (att blanda flera språk i en inspelning) är fortfarande utmanande. Modellen lär sig inte automatiskt ditt ordförråd; du måste berätta vad den kommer att höra.

Jämförelse av ekonomiska modeller

Prenumerationsbaserad molntranskription har löpande kostnader—debitering per minut eller månadsavgifter. Detta kan verka billigt för tillfälliga användare, men ackumuleras snabbt för tunga användare.

| Tjänst | Prismodell | 2-årskostnad |

|---|---|---|

| Otter.ai | $16.99/månad | $407 |

| Rev | $0.25/minut | Variabel |

| Whisper Notes | $4.99 engångs | $4.99 |

Ekonomin för lokal bearbetning är annorlunda: ett engångsköp (vårt pris är $4.99), sedan är marginalkostnaden nästan noll. Den extra kostnaden för att transkribera en 10-minutersinspelning kontra en 10-timmarsinspelning är densamma: noll.

Det handlar inte om att vara "billig", utan om förutsägbarheten i kostnadsmodellen. När ett verktyg inte debiterar per användning kan du använda det friare.

Praktiska funktioner

Varje funktion vi bygger är ett svar på ett observerat problem:

Låsskärmswidget

Vi observerade att de mest värdefulla inspelningarna ofta behövs plötsligt—ett ögonblick av inspiration, ett oväntat samtal, ett oväntat viktigt telefonsamtal. Inspelning med ett tryck från låsskärmen eliminerar denna barriär.

Spela in direkt från låsskärmen, missa aldrig inspirationen

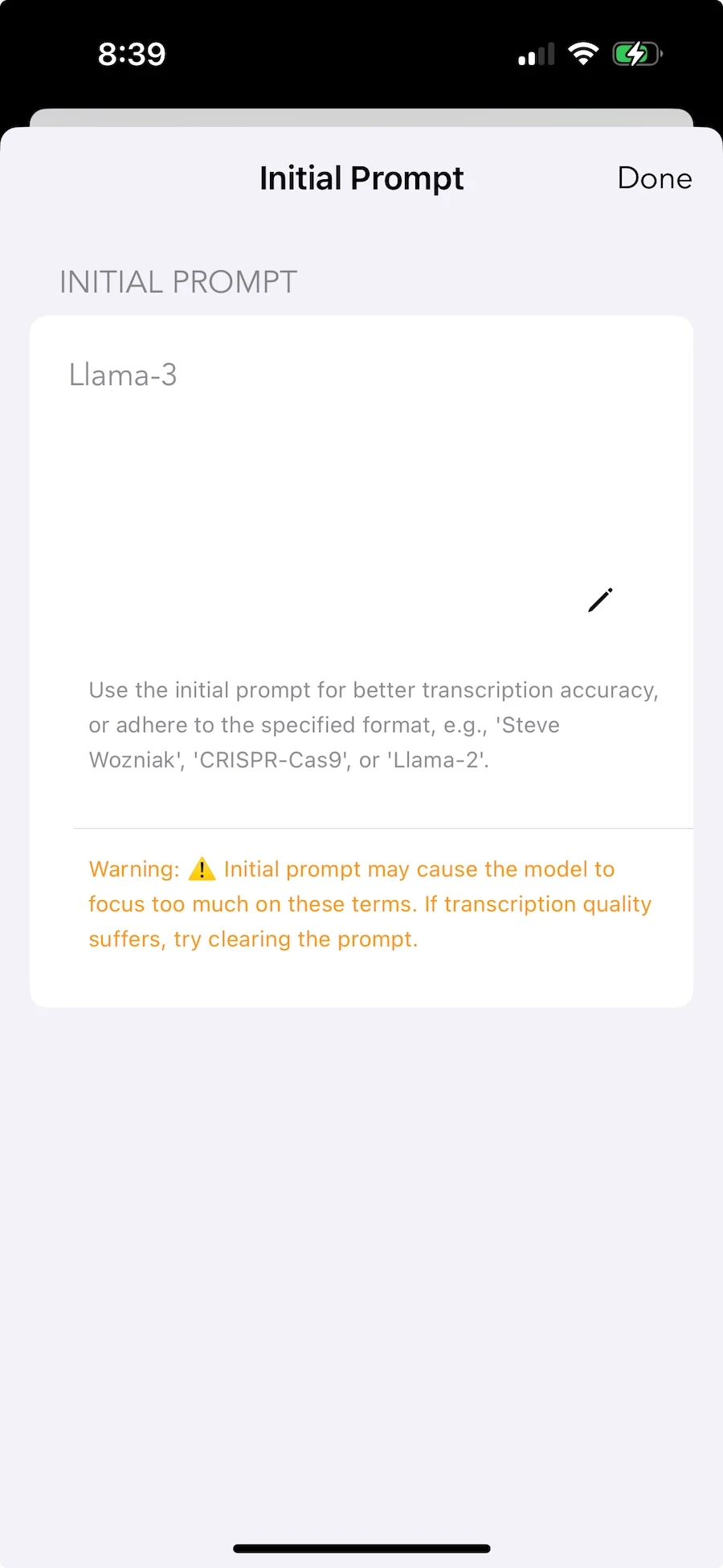

Inledande promptar (anpassat ordförråd)

Whisper presterar utmärkt på allmänt innehåll, men varje område har termer den inte känner igen. Medicinska termer, juridisk terminologi, interna namn, tekniska förkortningar. Inledande promptar låter dig berätta för modellen i förväg: "dessa ord kommer att dyka upp, känn igen dem korrekt".

Ställ in specialiserade termer för att förbättra igenkänningsnoggrannheten

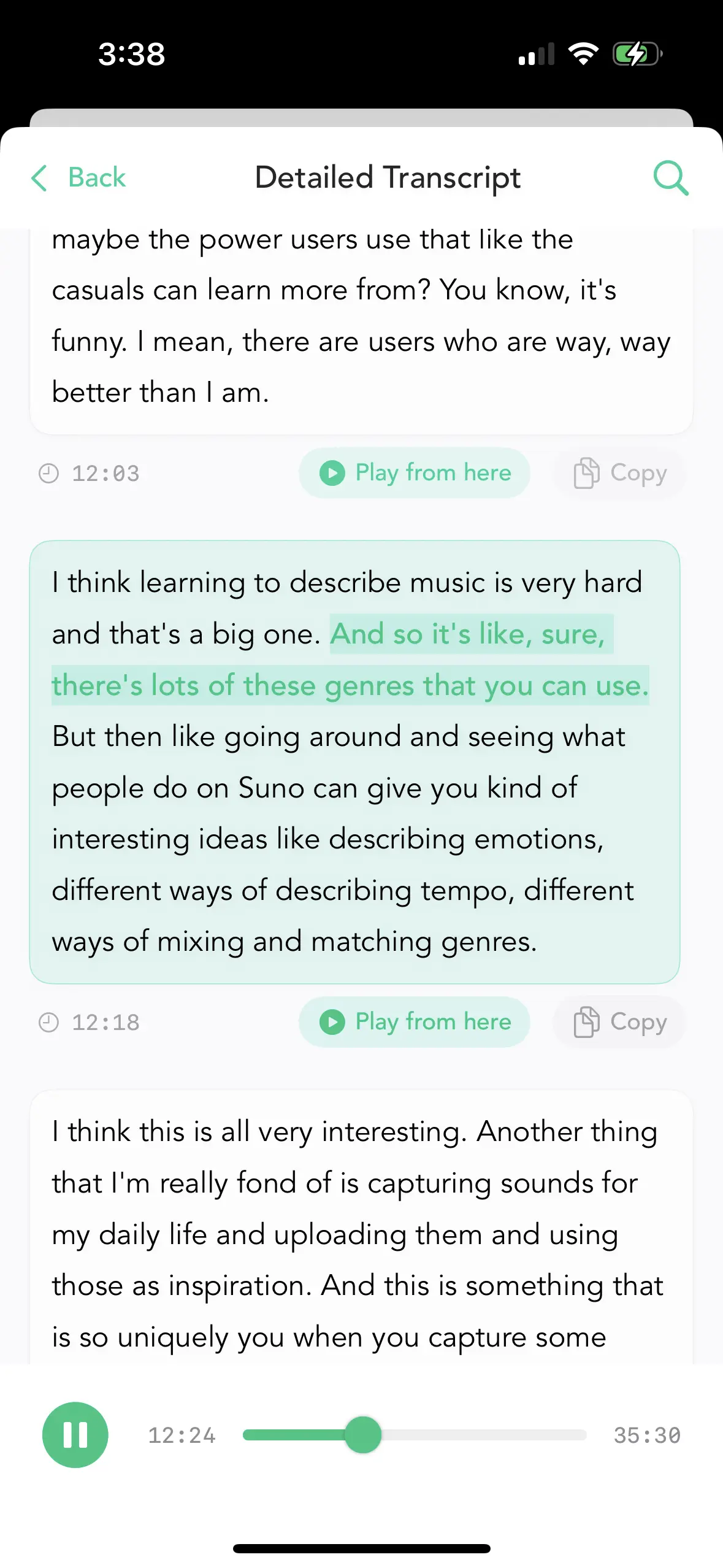

Tidsstämplade stycken

Värdet av långa inspelningar ligger ofta i specifika segment. Utan tidsstämplar måste du lyssna igenom hela inspelningen för att hitta den ena meningen. Med klickbara tidsstämplar kan du hoppa direkt till relevant del.

Lokalisera exakt med tidsstämplar, hoppa snabbt

Massexport

Forskare, journalister och advokater bearbetar ofta dussintals inspelningar åt gången. Att exportera en i taget är ett oacceptabelt arbetsflöde. Massoperationer gör detta praktiskt.

Välj flera, exportera allt på en gång

Flerspråkigt: 80+ språk

Whispers träningsdata täcker 99 språk, men djupet av täckning varierar. Stora språk som engelska, kinesiska, spanska, tyska och japanska har massiva mängder träningsdata och mycket hög noggrannhet. Mindre språk kan prestera något sämre, men är vanligtvis användbara.

Slutsats: Ett ingenjörsval

Vi byggde Whisper Notes eftersom lokal AI-inferens är överlägsen för rösttranskription—i latens, integritet, tillförlitlighet och kostnad. Det handlar inte om att vara "mot molnet" eller "tro på lokal-först". Det handlar om att erkänna att tekniska förhållanden har förändrats och bygga verktyg baserat på det.

Whisper Large-v3 Turbo på Mac och optimerade modeller på iPhone representerar den optimala balansen som nuvarande hårdvara faktiskt kan köra. När hårdvaran fortsätter att utvecklas—och det kommer den—distribuerar vi större modeller. Men även idag är lokal bearbetning tillräcklig för de flesta rösttranskriptionsuppgifter och överlägsen på viktiga mätvärden.

Om detta arkitektoniska tillvägagångssätt matchar dina behov kan du prova det nedan.