클라우드 전사는 죽었다. 단지 아직 스스로 모를 뿐이다.

당신의 휴대폰에는 Neural Engine이 있다. 사용하자.

지연 문제

클라우드 전사 파이프라인: 말하고, 오디오가 서버에 업로드되고, API가 처리하고, 결과가 돌아온다. "실시간" 서비스도 10초 녹음에 2-3초의 네트워크 왕복이 추가된다.

로컬 전사: 이 모든 지연이 사라진다. 오디오가 기기를 떠나지 않고, 처리는 칩에서 이루어지며, 결과는 즉시 나타난다. 업로드 없음, 대기 없음, "처리 중" 돌아가는 것 없음.

한편, 당신의 iPhone에는 초당 15조 연산이 가능한 Neural Engine이 있다. 그것이 놀고 있는 동안 당신의 목소리는 태평양을 왕복하고 있다.

이것은 물리적으로 터무니없다.

2019년에 클라우드 전사는 의미가 있었다. 휴대폰은 10억 파라미터 신경망을 돌릴 수 없었다. 그 제약은 더 이상 없다. iPhone 15 Pro는 대부분의 클라우드 서비스가 결과를 반환하는 것보다 빠르게 Whisper 모델을 실행한다. M3 MacBook은 60분 오디오를 5분에 처리한다—로컬에서, 오프라인으로, 업로드 없이.

클라우드 전사는 관성으로 살아남았다. 기술적 필요성이 아니라.

칩 값은 이미 냈다

신경 쓰이는 게 있을 것이다.

Apple M3 칩에는 프리미엄이 붙는다. 당신은 냈다. 그 Neural Engine? 당신 것이다. 머신 러닝에 최적화된 180억 개의 트랜지스터? 당신 것이다.

그리고 월 10달러를 Otter.ai에 내고 그들의 서버에서 오디오를 전사하게 한다.

자신의 하드웨어가 더 빠른데 남의 하드웨어를 빌리고 있다. 스포츠카를 사고 택시비를 내는 것과 같다.

클라우드 전사의 경제학은 로컬 추론이 불가능했을 때 의미가 있었다. 이제 그것은 단순한 관성세다. 3년 동안 월 10달러 구독은 360달러가 된다. Whisper Notes는 4.99달러, 한 번만. 같은 정확도. 더 빠른 처리. 당신의 칩이 설계된 대로 일한다.

| 서비스 | 1년차 | 3년차 | 5년차 |

|---|---|---|---|

| 클라우드 구독 ($10/월) | $120 | $360 | $600 |

| Whisper Notes (일회성) | $4.99 | $4.99 | $4.99 |

우리는 구독료를 청구하지 않는다. 서버를 운영하지 않기 때문이다. 당신의 오디오는 우리 인프라에 닿지 않는다. 월별로 청구할 것이 없다.

데이터 유출은 아키텍처 문제

프라이버시에 대해 직접적으로 말하자.

클라우드 전사 서비스를 사용하면 당신의 오디오는 다른 사람의 서버에 존재한다. 그 서버에는 접근 권한을 가진 직원이 있다. 그 서버는 네트워크에 연결되어 있다. 그 네트워크는 공격에 직면해 있다. 데이터 유출은 사고가 아니다—제3자 인프라에 민감한 데이터를 저장하는 것의 구조적 필연이다.

음성 데이터에는 고유한 위험이 있다. 비밀번호와 달리, 목소리는 리셋할 수 없다. 성문은 영구적인 생체 인식 식별자다. 한 번 유출되면 영원히 유출된 상태다. 공격자는 성문을 인증 우회, 신원 사기, 딥페이크 생성에 사용할 수 있다.

이 위험을 제거하는 유일한 방법은 업로드를 제거하는 것이다. 장치를 떠나지 않는 오디오는 서버 측 유출의 일부가 될 수 없다. 이것은 기능이 아니다—물리다.

누가 민감한 오디오를 녹음하는지 생각해보자:

- 변호사가 고객 상담을 녹음

- 치료사가 환자 세션을 기록

- 기자가 정보원을 보호

- 임원이 전략적 논의를 캡처

- 의사가 환자 기록을 작성

이들 전문가에게 클라우드 스토리지는 불편한 것만이 아니다—책임 위험이다. 로컬 전사는 선호가 아니다. 요구 사항이다.

정확도에 대하여: 솔직한 트레이드오프

로컬 전사가 잘하는 것과 못하는 것을 솔직하게 말할 필요가 있다.

로컬 Whisper가 더 잘하는 것: 축어적 전사. 말한 것을 정확히 기록해야 한다면—모든 단어, 모든 멈춤, 모든 "음"—로컬 Whisper 모델이 뛰어나다. 깨끗한 오디오에서 5-8%의 단어 오류율은 인간 전사자와 동등하다. 말한 것에 충실한 전사.

클라우드 AI가 더 잘하는 것: 요약과 추출. GPT-4o는 회의를 듣고 액션 아이템, 요약, 후속 작업을 생성할 수 있다. 문자 그대로의 의미를 넘어 문맥을 이해한다. "어떤 결정이 내려졌는지 알려줘"가 원하는 것이라면, 클라우드 AI가 진짜로 더 낫다.

트레이드오프는 실제다. 워크플로우가 "전사 → Claude/GPT로 요약"이라면 양쪽의 장점을 모두 얻을 수 있다: 정확한 로컬 전사, 지능적인 클라우드 요약. 원본 오디오는 프라이빗하게 유지. 공유하기로 선택한 텍스트만 장치를 떠난다.

로컬 AI가 모든 것을 해결한다고 주장하지 않는다. 각 작업에 적합한 도구를 사용하는 것을 믿는다. Whisper는 전사에 적합한 도구. LLM은 이해에 적합한 도구. 그것들을 조합하여—프라이버시가 중요한 곳에서는 로컬, 지능이 중요한 곳에서는 클라우드—이것이 솔직한 접근 방식이다.

| 작업 | 최적의 도구 | 이유 |

|---|---|---|

| 축어적 전사 | 로컬 Whisper | 프라이버시, 속도, 정확도 |

| 회의 요약 | 클라우드 LLM (전사에 대해) | 문맥 이해 |

| 액션 아이템 추출 | 클라우드 LLM (전사에 대해) | 의미 추론 |

| 실시간 협업 | 클라우드 서비스 (Otter 등) | 다중 사용자 조정 |

실제 속도 데이터

M3 MacBook Pro에서 Whisper Large-v3 Turbo는 오디오를 약 실시간의 12배 속도로 처리한다. 60분 녹음이 약 5분에 완료.

iPhone 15 Pro에서 최적화된 모델은 약 실시간의 5배 속도로 실행된다. 같은 60분 녹음이 약 12분.

클라우드 서비스와 비교:

| 녹음 시간 | 클라우드 (일반적) | M3 Mac (로컬) | iPhone 15 Pro (로컬) |

|---|---|---|---|

| 5분 | 45-90초 | ~25초 | ~60초 |

| 30분 | 3-6분 | ~2.5분 | ~6분 |

| 60분 | 6-12분 | ~5분 | ~12분 |

로컬 처리는 대부분의 녹음 길이에서 클라우드 속도와 동등하거나 더 빠르다. 그리고 비행기 안, 지하실, 보안 시설 내—연결이 없는 곳에서도 작동한다.

우리의 구현 방법

Whisper Notes는 이러한 원칙의 구현이다. 몇 가지 구체적인 설계 결정에 대해:

잠금 화면 위젯

최고의 아이디어는 불편한 순간에 온다. 잠금 화면 위젯을 만들었다—한 번 탭으로 녹음 시작, 앱 열 필요 없음, 인증 없음, 연결 확인 없음. 로컬 처리는 즉시 사용 가능을 의미한다.

한 번 탭으로 녹음. 네트워크 의존성 제로.

하드웨어 적응형 모델

Mac에는 열적 여유와 충분한 전력이 있다. iPhone은 주머니 속에 있다. 각각에 다른 모델 구성을 배포: Mac에는 Whisper Large-v3 Turbo (8.09억 파라미터), iPhone에는 최적화된 소형 모델. 같은 프라이버시 보장, 적절한 리소스 사용.

당신의 데이터, 당신의 파일

전사는 장치의 파일이다. 표준 포맷, 표준 위치. 독점 데이터베이스 없음, 벤더 종속 없음. Whisper Notes가 내일 사라져도 녹음에 접근할 수 있다. 대량 내보내기는 프리미엄 기능이 아니다—소유한 데이터의 자연스러운 상태다.

당신의 데이터. 당신의 포맷. 당신의 목적지.

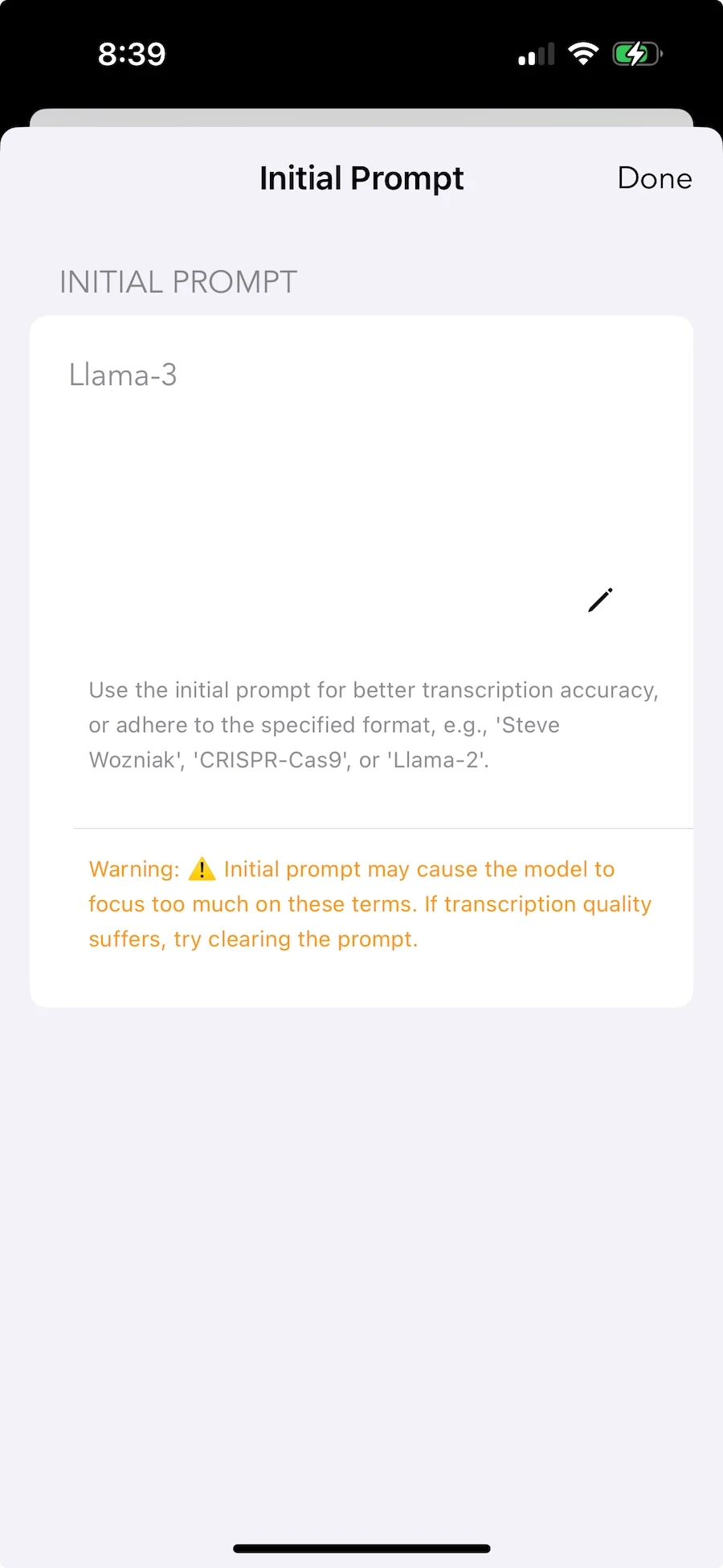

커스텀 어휘

기술 용어, 드문 이름, 전문 용어—가장 정확한 전사가 필요한 어휘는 종종 가장 업로드하고 싶지 않은 것이다. 초기 프롬프트로 로컬에 컨텍스트를 추가할 수 있다. 모델이 조정되고 용어가 훈련 데이터가 되지 않는다.

로컬 개인화. 어휘는 프라이빗하게.

클라우드가 더 나은 경우

로컬 전사가 보편적으로 더 낫다고 주장하지 않는다. 클라우드에는 진정한 이점이 있다:

실시간 팀 협업. 회의 중 5명이 동시에 전사를 편집하려면 서버 조정이 필요하다. 로컬 도구는 본질적으로 단일 사용자다.

대규모 화자 식별. 다중 화자 녹음에서 "누가 무엇을 말했는지"는 클라우드 규모의 훈련 데이터로부터 혜택을 받는다. 온디바이스 다이어라이제이션은 존재하지만 대그룹에서는 정확도가 낮다.

워크플로우 자동화. 클라우드 서비스는 CRM에 연결하고, 액션 아이템을 추출하고, Slack에 요약을 보낸다. 로컬 도구는 텍스트 파일을 생성한다—그것으로 무엇을 하는지는 수동이다.

오래된 하드웨어. A14 이전의 iPhone, Intel Mac—일부 장치는 실질적으로 로컬 추론을 실행할 수 없다. 클라우드가 유일한 옵션.

솔직한 평가: 주요 필요가 라이브 미팅 중 팀 협업이라면 클라우드 도구가 아마 더 낫다. 주요 필요가 프라이버시를 가지고 자신의 녹음을 전사하는 것이라면 로컬 도구가 올바른 아키텍처다.

트렌드

칩 세대마다 Neural Engine 성능이 향상된다. 모델 반복마다 효율이 향상된다. 로컬과 클라우드의 격차는 줄어들고, 프라이버시와 지연 시간 이점은 불변이다.

클라우드 전사는 휴대폰이 이 작업을 할 수 없었을 때 의미가 있었다. 그 시대는 2022년경에 끝났다. 남은 것은 관성—자동 갱신되는 구독, 서버 가정으로 구축된 워크플로우, 클라우드가 더 나을 것이라는 막연한 믿음.

문제는 로컬 전사가 작동하는지 여부가 아니다. 작동한다. 문제는 이미 소유한 하드웨어에 임대료를 계속 낼 것인지이다.

기술 세부 사항

장치 요구 사항: iPhone 12+ (A14 칩) 또는 M 시리즈 칩의 Mac. 오래된 장치는 기술적으로 작동하지만 처리 시간이 실용적이지 않다.

모델: Mac은 Whisper Large-v3 Turbo (8.09억 파라미터)를 실행. iPhone은 모바일 제약에 맞게 조정된 하드웨어 최적화 변형을 실행.

속도: M3 Mac: ~12배 실시간. iPhone 15 Pro: ~5배 실시간.

언어: 100+ 종, 자동 감지.

가격: $4.99 일회성. 서버를 운영하지 않으므로 구독 없음.